Magica et Technica

Autos

-Audi 80

-Ford Mondeo

-Nachrüsten

-Gimmicks

-Sonstiges

Videos

-Video digitalisieren und restaurieren

-Videoschnitt mit Media Studio Pro

-Bildfilter - Was funktioniert wie?

-Videomedien für Consumer und Profis

Fotos

Computer

Handwerk

Videos digital restaurieren und konservieren

Nur ein weiterer Guide? Weit gefehlt, denn was im Internet teilweise über Videobearbeitung am PC steht ist größtenteils haarsträubend. Leider protzen viele mit ihrem zusammengeklauten Halbwissen und verleiten andere dazu, ihre Videos in schlechter Qualität und/oder falschen Größenverhältnissen abzuspeichern. Auch ich bin nicht fehlerfrei und habe sicher noch den ein oder anderen sachlichen Fehler im Text versteckt, somit wäre ich für Hinweise auf ebensolche dankbar, jedoch versuche ich so gut wie möglich mit Mißverständnissen und falschen Hoffnungen aufzuräumen: Das hochwertige digitalisieren von analogen Videos geht nicht schnell, ist nicht billig und schon garnicht einfach, jedoch mit dem nötigen Vorwissen, etwas Übung und einem guten Händchen beim Einkauf preiswert und ohne viel Zeitaufwand umzusetzen. Wer viel Theorie, lesen und experimentieren scheut sollte besser gleich ganz die Finger vom Thema Digital-Video lassen. Allerdings ist vieles nicht so schlimm wie es aussieht und leicht verständlich. Und wer die Grundprinzipien verstanden hat und sich die wenigen wichtigen Zahlen eingeprägt hat und am besten auch noch bereit ist, ein wenig Geld für das Hobby auszugeben, wird viel Spaß an der Materie finden und Videos remastern wie ein Profi im Studio.

Ich will hier nicht viel mit Bildern protzen sondern viel mehr sachlich und anhand von Text, Tabellen, Illustrationen und natürlich auch ein paar Bildern erklären, wie man Schritt für Schritt zum idealen Video kommt. Während andere Guides oft garkeine Bilder und Illustrationen vorweisen, und wieder andere lesen sich wie ein Bildband. Ich hoffe, den Spagat zwischen illustriert und bebildert und sachlichen Texten halbwegs zu schaffen. Der Guide beschäftigt sich auch einzig und allein mit Aufnahme und Konservierung, denn für Schnitt sind nur zwei Sachen wichtig: Ein Schnittprogramm das gut in der Hand liegt und Kreativität. Zu ersterem kann ich keine Empfehlung aussprechen da dies individuell empfunden wird, letzteres hat man oder man hat es nicht. Kreative Hilfestellungen und Anregungen zum Kauf eines Videoschnittprogrammes gebe ich im zweiten Video-Guide, zum Thema Videoschnitt am Beispiel von Anime Musikvideos.

Zur Zielgruppe: Der Guide richtet sich primär an Anfänger und soll außerdem einige letzte Irrglauben semiprofessioneller Anwender korregieren. Eben diese semiprofessionellen Anwender sind unter Umständen nicht ganz einverstanden mit meiner Ausdrucksweise. Klar ist es immer sinnvoll, die Fachausdrücke zu benutzen und den Anfängern von anfang an beizubringen. Somit versuche ich auch, möglichst viele Fachbegriffe zumindest einmal einzuarbeiten und zu erklären. Allerdings soll ein Guide für Anfänger vor allem eines sein: Anschaulich und übersichtlich. Ich bitte somit, zu verzeihen, wenn ich statt "PAL Square Pixel" mal "PC-4:3" rede um klar zu machen "so sieht das Seitenverhältnis am PC aus", während die CCIR-601 Norm - der Anschaulichkeit halber "Fernseh-4:3" genannt - das Seitenverhältnis am Fernseher mit den leicht in die Breite gezogenen Pixeln darstellt.

Schritt 1: Theoretische Grundlagen

Schritt 2: Auswahl der Hardware

Schritt 3: Anschließen und Aufnahme

Schritt 4: Störungen und ihre Beseitigung

Schritt 5: Aufbereitung

Schritt 6: Abspeichern auf dem entgültigen Medium

Schritt 1: Theoretische Grundlagen

Auch hier ist Theorie von Nöten denn der erste verwirrende Punkt ist das Auflösungs-Wirrwarr in der Videoverarbeitung. Ein PC hat einen 4:3 Monitor mit quadratischen Pixeln. Daher laufen PC-Monitore in der Regel auch mit 4:3 Auflösungen. Besonders deutlich wird das bei 800x600 -> 800/4*3=600. Zwar bieten alle Grafikkarten 1280x1024 an wo diese Rechnung nicht aufgeht, jedoch war das auch nur eine Notfall-Norm aus Zeiten als Speicher noch teuer war. Diese Auflösung wird heutzutage von TFT-Panels in der Größenordnung 17-19" benutzt die dann auch ein der Auflösung entsprechendes 5:4 Panel-Seitenverhältnis haben womit die Pixel wieder entzerrt wären. Auf einem 4:3-Monitor sähe das Bild leicht gequetscht aus. Vollbild-Videos im 4:3-Verhältnis laufen mit leichten Balken oben und unten. Für Besitzer von 4:3 Röhrenmonitoren bieten die meisten Grafikkarten die Quadratpixel-Auflösung 1280x960 an. Wobei auch PCs nicht immer Quadratpixel hatten, wie z.B. die CGA-Auflösung 320x200, die EGA-Auflösung 640x350 oder ganz extrem die Hercules-Auflösung mit satten 720x348 Pixeln zeigen.

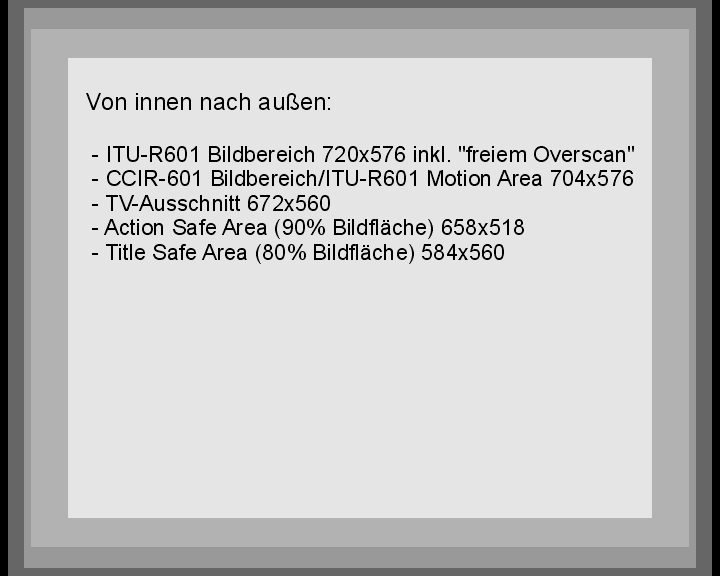

Auch ein Fernseher ist 4:3 allerdings lautet die Auflösung hier nicht 768x576 sondern 720x576 bzw. 704x576 Motion Area. Der TV-Ausschnitt liegt sogar nur bei 672x560. Das sieht natürlich nicht sonderlich 4:3 aus wenn man rechnet, das liegt allerdings daran, daß die ITU-R-601 Norm leicht in die Breite gezogene rechteckige Pixel vorsieht und dann stimmt es wieder.

Auflösung? TV-Ausschnitt? Was soll das? Alte Fernseher hatten noch keine sonderlich stabile Hochspannung die sowohl für den Kathodenstrahl in der Bildröhre alsauch für die Ablenkeinheiten benötigt wird. Bei hellen Bildern zog sich das Bild daher auseinander, bei dunklen Bildern zog es sich zusammen. Man spricht hierbei von "pumpen". In Abspännen mit dunklem aber nicht schwarzen Bild im Hintergrund und heller Schrift ließ sich sogar beobachten wie sich das Bild in den Zeilen mit Text in die Breite auseinanderzog während es an dunklen Stellen ohne Text zusammenzog. Man hatte also sogar leichte Wellenlinien im Bild. Um diesen Effekt zu vertuschen arbeitet ein Fernseher "overscan", sprich Teile des Bildes werden einfach außerhalb des Bildbereiches projiziert, sodaß selbst wenn sich das Bild an dunklen Stellen zusammenzieht immer noch Bild und nicht einfach nur schwarz da ist. Der TV-Ausschnitt ist der Bereich, der ein Bild enthalten muß damit das ganze Bild ohne Rand sichtbar ist. Alles andere, sowie in der Regel auch noch ein Teil des TV-Ausschnittes liegt im Overscan. Diesen Effekt kann man sich zu Nutze machen um ein paar Pixel außerhalb des TV-Ausschnittes einzuschwärzen. Am Fernseher sind die schwarzen Ränder nicht sichtbar, da sie im Overscan liegen, am PC-Monitor mit Underscan/Fullscan würde sich ein schwarzer Rand zu sehen sein, der jedoch deutlich schöner aussieht als irgendwelche ausgefransten flirrenden Ränder oder VHS Head Switch Noise, die Störstreifen die jeder VHS-Recorder im unteren Bildrand verursacht. Außerdem gibt es systembedingt noch einen kleinen Bereich der keine Nutzdaten enthält. 4:3 nach ITU-R-601 entspricht strenggenommen 704x576, (4:3 Auflösung nach CCIR 601). Die 16 Pixel, die fehlen, sind der systembedingte Raum ohne Nutzdaten der neuen erweiterten ITU-R 601, die weiterhin eine Motion Area von 704x576 hat. Grund für die Erweiterung des Bereiches ist unter Anderem, daß man etwas Reserve hat, damit keine Informationen aufgrund von vertikalem Jitter (wabernde Ränder, z.B. durch Gleichlaufschwankungen von Bandlaufwerken) verloren gehen.

Um das Thema Auflösungen und Bildbereiche

abzuschließen möchte ich nach Vollbild, Motion Area und TV-Ausschnitt

auch noch die Safe Area erwähnen: Die Safe Area bezeichnet den Raum in

dem Einblendungen liegen müssen (z.B. Texteinblendungen, Bildeinblendungen

oder Buttons in DVD-Menüs) damit sie nicht am Fernseh-Rahmen kratzen oder

unter selbigen verschwinden wenn ein Fernseher mal etwas mehr Overscan hat.

Die genauen Bereiche sind nicht exakt definiert, allerdings gelten folgende

Leitwerte: Man unterscheided zwischen der Action Safe Area und der Title Safe

Area. Die Action Safe Area beträgt etwa 90% der Bildfläche. Dieser

Bereich ist auf dem Fernseher sichtbar, alles darüber hinaus landet im

Overscan. Die Title Safe Area ist der sichere Bereich für Titeleinblendungen

die garantiert im Bild sein sollen und nicht unschön am Rand kratzen sollen.

Ein Senderlogo oder ein Knopf in einem DVD-Menü würde in der Action

Safe Area etwas deplaziert wirken, da man es in der Ecke kaum wahrnimmt und

es evtl. unschön direkt am Rand kratzen oder leicht unter ihm verschwinden

würde. Was beim Senderlogo jedoch noch erträglich ist, und beim DVD-Knopf

schon mehr stört, ist bei Untertiteln und ähnlichen Einblendungen

richtig unschön. Die sollten wirklich nicht am Bildrand kratzen. Ein Senderlogo

wird in der Regel am Rand der Title Safe Area platziert, die 80% der Bildfläche

beträgt. Die Einblendungen der Safe Area Markierungen in Vegas 5 haben

die Größe 658x518 für die Action Safe Area und 584x460 für

die Title Safe Area. Beide Werte gelten für PAL (aufgrund der anderen Zeilenauflösung

sind sie für NTSC natürlich anders) und sind mittig auf dem Vollbild

zu platzieren.

Um das Thema Auflösungen und Bildbereiche

abzuschließen möchte ich nach Vollbild, Motion Area und TV-Ausschnitt

auch noch die Safe Area erwähnen: Die Safe Area bezeichnet den Raum in

dem Einblendungen liegen müssen (z.B. Texteinblendungen, Bildeinblendungen

oder Buttons in DVD-Menüs) damit sie nicht am Fernseh-Rahmen kratzen oder

unter selbigen verschwinden wenn ein Fernseher mal etwas mehr Overscan hat.

Die genauen Bereiche sind nicht exakt definiert, allerdings gelten folgende

Leitwerte: Man unterscheided zwischen der Action Safe Area und der Title Safe

Area. Die Action Safe Area beträgt etwa 90% der Bildfläche. Dieser

Bereich ist auf dem Fernseher sichtbar, alles darüber hinaus landet im

Overscan. Die Title Safe Area ist der sichere Bereich für Titeleinblendungen

die garantiert im Bild sein sollen und nicht unschön am Rand kratzen sollen.

Ein Senderlogo oder ein Knopf in einem DVD-Menü würde in der Action

Safe Area etwas deplaziert wirken, da man es in der Ecke kaum wahrnimmt und

es evtl. unschön direkt am Rand kratzen oder leicht unter ihm verschwinden

würde. Was beim Senderlogo jedoch noch erträglich ist, und beim DVD-Knopf

schon mehr stört, ist bei Untertiteln und ähnlichen Einblendungen

richtig unschön. Die sollten wirklich nicht am Bildrand kratzen. Ein Senderlogo

wird in der Regel am Rand der Title Safe Area platziert, die 80% der Bildfläche

beträgt. Die Einblendungen der Safe Area Markierungen in Vegas 5 haben

die Größe 658x518 für die Action Safe Area und 584x460 für

die Title Safe Area. Beide Werte gelten für PAL (aufgrund der anderen Zeilenauflösung

sind sie für NTSC natürlich anders) und sind mittig auf dem Vollbild

zu platzieren.

(Um das Bild mit den Bildbereichen auf voller Größe zu sehen auf das Bild klicken, dann öffnet sich ein neues Fenster)

Nun arbeiten TV-Karten damit das Bild am PC nicht verzerrt ist mit einer PC-4:3 Auflösung. Da die Anzahl der Zeilen fest definiert ist und vom Synchronisationstakt bestimmt wird kann nur in einer Zeile die Anzahl der Punkte variiert werden. PAL gibt 576 Zeilen vor, NTSC 486 (von denen in der Regel nur 480 abgetastet werden da 6 keine wichtigen Daten enthalten und 486 nicht durch die magische Zahl 16 teilbar ist). Beidemale sind in der ITU-R-601 720 Pixel pro Zeile festgelegt. Wie gesagt in der Höhe lassen sich keine Informationen einsparen ohne nachträglich aufwändig zu skalieren, also ändert man die Anzahl der Informationen in der Breite die nicht getaktet ist. Bei PAL erweitert sich so die Anzahl der abgetasteten Punkte von 704 (von 720 wovon ja 16 unwesentlich sind) auf 768. Das mag im ersten Augenblick ja besser klingen weil man ja mehr Punkte hat. Da diese aber nicht vorgesehen sind kann dies beim runterskalieren für DVD oder beim Rückspielen auf den Fernseher zu leichten Bildfehlern wie Flimmern entlang senkrechter Striche oder Informationsverlust (da andere Pixel weggelassen/depoliert werden als beim Abtasten interpoliert/dazuerfunden wurden) führen. Eine Überabtastung mit mehr als den 704/720 Punkten ist nur dann sinnvoll wenn man die Abtastfrequenz deutlich höher wählt als die des Bildes, mit 768 statt 704 kommt man aus den oben genannten Gründen jedenfalls in Teufels Küche. NTSC erwischt es andersrum ganz böse: Da hier nur 480 (bzw. 486) Zeilen zur Verfügung stehen bedeutet dies auf PC-4:3 umgerechnet, daß nur noch 640 Punkte pro Zeile abgetastet werden. Informationsverlust pur.

Für die, die es ganz genau nehmen, natürlich hat eine Fernseh-Zeile keine physikalsichen Pixel. Jedoch eine Videobandbreite und die beträgt 6,75MHz. Der Hobby-Elektroniker hat vielleicht schon mal vom Abtast-Theorem nach Shannon gehört: Man benötigt mindestens die doppelte Frequenz des Signals um es vernünftig abzutasten. Das macht 13.5MHz. Die Dauer einer Zeile bzw. deren sichtbarem Bereich ist nach CCIR601 auf 52µs definiert. Und 0.000052s * 13500000/s ergibt 702, die eigentliche Pixelanzahl nach CCIR-601 (man nutzt jedoch 704 weil die Verzerrung nicht sichtbar und nicht messbar ist und 702 nicht durch 16 teilbar ist, 704 jedoch schon). Mehr abtasten würde bei einem analogen Signal theoretisch nicht schaden. Praktisch dürfte es jedoch Probleme mit sich bringen: Heutzutage wird viel digital gearbeitet. Hier hält man sich an die CCIR-601 bzw. ITU-R601 Norm. Selbst wenn man in der Produktion noch eine Fast Video Machine mit PC-4:3-Verhältnis (PAL Square Pixel) einsetzt, man kann sich fast immer sicher sein, daß das Ergebnis irgendwann auf Digital Betacam landet (und somit ITU-R601 konform abgetastet wurde) oder digital übertragen wurde (vermutlich ebenfalls in ITU-R601 Auflösung). Wurde das Signal gut übertragen trifft man bei CCIR/ITU-R601 Abtastung immer den Farbwert an den man antreffen will. Aber was tastet man ab wenn die Abtastfrequenz erhöht wird um Quadratpixel zu erhalten? Den gleichen Pixel doppelt? Irgendwelche "Zwischenpixel" (z.B. grau zwischen einem schwarz-weiß-Wechsel)? Und was passiert wenn man wieder herunterskaliert? Skalieralgorithmen, je nach Qualität, tasten auch nur ab, sprich sie lassen Pixel weg - evtl. jedoch nicht die "dazuerfundenen" sondern andere. Andere Skalieralgorithmen blenden zwei Pixel ineinander - aber welche? Qualitäts- und Informationsverluste sind die Folge, bei hohen Frequenzen wie dem berühmten Karo-Jackett bekommt man nur noch mehr Probleme mit den allseits bekannten und verhassten Moire-Mustern als bei "normgerechter" Abtastung ohne Skalierung.

Ich erwähnte vorhin die magische Zahl 16: Damit weniger Verwaltungsaufwand entsteht, sind Videos so abgespeichert, zerlegt man Videos in 16x16 Blöcke. Manche Codecs (insbesondere MPEG-basierte Codecs wie MPEG1, MPEG2 und die MPEG4-Derivate DivX, Xvid, Windows Media, ...) sind hierrauf abgestimmt und auch die hardwarebeschleunigte Wiedergabe und Overlay funktionieren nur mit 16x16-zerlegbaren Videos. Wer z.B. einfach nur den VHS Head Switch Noise am unteren Bildrand ersatzlos wegschneidet (z.B. aus einem 640x480 Bild ein 640x470 macht) verfälscht zwar nicht das Seitenverhältnis, da immer 1:1 skaliert wird und somit bei der Vollbildwiedergabe automatisch ein schwarzer Rand entstehen würde, allerdings kann es zu Problemen bei der Wiedergabe kommen. Es kann von vielen Faktoren abhängen, ob ein solches Video korrekt wiedergegeben wird, Grafikchip, Grafiktreiber, Video-Codec, Video-Wiedergabeprogramm, Mainboard-Chipsatz, CPU, Betriebssystem, ... Das Ergebnis dieser rein softwarebasierten Wiedergabe (Framebuffer statt hardwarebeschleunigtes Overlay) ist eher rein zufällig. Das Video kann auf einem Celeron 400 ruckelfrei laufen - oder aber auf einem Pentium-III mit 1GHz ruckeln. Moderne aktuelle Systeme sollten genug Rechen-, Bus- und Grafikpower haben um allesamt diese Videos korrekt wiedergeben zu können, könnten allerdings auch in ihre Leistungsgrenzen gelangen wenn eine Komponente dieses krumme Darstellungsformat nicht mag. Die Fernseh-Auflösungen sind allesamt kein Problem. 576 Zeilen bei PAL und 480 bei NTSC (offiziell sind es 486 Zeilen, allerdings ist die Pinnacle DC50 die einzige mir bekannte Karte die die vollen 486 Zeilen abtastet, wichtig sind die 6 zusätzlichen Zeilen nicht, und auf DVD auch nicht vorhanden da hier die 16x16 Regel greift und 486 nicht durch 16 teilbar ist) sind kein Problem, auch die Zeilenauflösungen von 704, 720, 640 oder 768 Punkten sind kein Problem. Etwas ungünstig wäre einzig, wenn man 720 Punkte auf PC-übliche Quadratpixel hochskalieren will, dabei ergibt sich 786 Punkte was nicht durch 16 teilbar ist. Da die Motion Area jedoch nur 704 Pixel beträgt und 704 Fernseh-Pixel den 768 PC-Pixeln entsprechen ist es sowieso sinnvoll, beim Skalieren zwischen den Seitenverhältnissen auf die Motion Area zu croppen. Einzig von 720 auf 768 Pixel zu skalieren oder von 768 auf 720 zu skalieren oder auf 720 oder 704 zu croppen wäre ein böser Fehler. Da man bei DVDs auf die TV-Auflösungen festgenagelt ist kommt man hier garnicht erst in Versuchung auf krumme Auflösungen zu croppen oder resizen.

NTSC interessiert uns nur nebenläufig da viele sicher keine NTSC-Bänder besitzen und die meisten Videorekorder NTSC auch als "PAL60" (NTSC Auflösung und Frequenz, PAL-Farbträger) abspielen was schon wieder eine andere Baustelle ist und von vielen Karten auch nicht unterstützt wird. Bei PAL haben wir also 576 Zeilen und:

ITU-R-601 Full-D1: 720 Pixel

ITU-R-601 Motion Area (alias CCIR 601): 704 Pixel

Squre Pixel (PC-4:3): 768 Pixel

Da man für DivX (was ja immer noch hauptsächlich am PC verwendet und auch im Square-Pixel Verhältnis von Standalone-DivX-Playern entzerrt wird) und für Screenshots für Internet und Text Square-Pixel benötigt, für DVD jedoch ITU-R-601 hier eine Umrechnungstabelle:

Ich habe ->

Ich brauche \/\/\/\/ |

CCIR-601 Viertelbild 352x288 (VCD) |

ITU-R-601 Motion Area/CCIR601 (TV-4:3) 704x576 (DVD, nicht empfehlenswert) |

ITU-R-601 Full-D1 720x576 (DV, DVD) |

Square Pixel (PC-4:3) Viertelbild 384x288 |

Square Pixel (PC-4:3) Vollbild 768x576 |

CCIR-601 Viertelbild 352x288 (VCD) |

Skalieren auf 352x288 |

Links und rechts je 8 Punkte wegschneiden und auf 352x288 skalieren |

Auf 352x288 skalieren |

Auf 352x288 skalieren |

|

ITU-R-601 Motion Area/CCIR601 (TV-4:3) 704x576 (DVD, nicht empfehlenswert) |

Skalieren auf 704x576 |

Links und rechts je 8 Punkte wegschneiden |

Auf 704x576 skalieren |

Auf 704x576 skalieren |

|

ITU-R-601 Full-D1 720x576 (DV, DVD) |

Skalieren auf 704x576, links und rechts je 8 Punkte letterboxen |

Links und rechts je 8 Punkte letterboxen |

Auf 704x576 skalieren und auf beiden Seiten je 8 Punkte letterboxen |

Auf 704x576 skalieren und auf beiden Seiten je 8 Punkte letterboxen |

|

Square Pixel (PC-4:3) Viertelbild 384x288 |

Skalieren auf 384x288 |

Skalieren auf 384x288 |

Links und rechts je 8 Punkte wegschneiden und auf 384x288 skalieren |

Auf 384x288 skalieren |

|

Square Pixel (PC-4:3) Vollbild 768x576 |

Skalieren auf 768x576 |

Skalieren auf 768x576 |

Links und rechts je 8 Punkte wegschneiden und auf 768x576 skalieren |

Auf 768x576 skalieren |

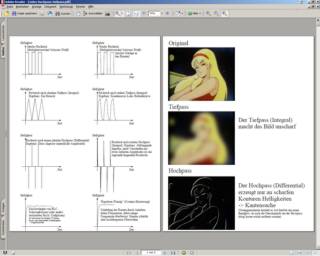

Die Hintergründe für Schärfe und Unschärfe: Zum Abschluß des Theorie-Kapitels möchte ich auch hierrauf noch mal kurz eingehen. Warum wird ein Video beim Umkopieren unscharf? Ein Videosignal besteht aus Helligkeit - einem Amplitudensignal - und bei Consumergeräten die nicht mit Komponentenvideo arbeiten aus einer Farbinformation in Form eines Sinus-Signals das mit Amplitude und Phase die Farbe bestimmt. Die Farbe ist weniger anfällig da zum einen kein Amplitudesignal sondern ein Sinus, zum anderen auch weil das menschliche Auge Farbe schlechter unterscheiden kann als Helligkeit. Die Farbbandbreite wurde zwecks Platzersparnis schon immer stark reduziert, zum einen in der analogen Aufzeichnung, zum anderen z.B. auch im Digitalen wo z.B. Farbräume wie YUV 4:1:1 oder 4:2:0 Anwendungen finden wo auf mehrere Helligkeitspixel nur ein Farbpixel trifft. YUV 4:4:4 oder RGB sind bei stark komprimierten Daten selten da man sich am ehesten zur Platzersparnis überflüssigen Informationen entledigt bevor man anfängt verlustbehaftet zu komprimieren.

Das Helligkeitssignal in der Natur eines Amplitudensignals und weil es einfach stärker auffällt leidet jedoch stärker. Was ist ein Helligkeitswechsel schwarz-weiß? Ein Sprung. Und was sind viele Helligkeitswechsel Schwarz-weiß-schwarz-weiß...? Ein Rechtecksignal. Und was ist ein Rechteck? Eine Überlagerung unendlich vieler Sinusschwingungen (Rect(f)=Sin(f)+1/3Sin(3f)+1/5Sin(5f)+...), allerdings je hochfrequenter desto niedriger die Amplitude. Jede analoge Überspielung hat den Charakter eines Tiefpasses, heißt hohe Frequenzen werden abgedämpft. Der Effekt des Verschwindens der hohen Frequenzen: Ein Effekt der mathematisch an ein Integral erinnert. Ein Tiefpass ist also ein Integral (Ideal: Die Fläche unter einer Funktion - heißt aus einem Sprung wird eine Rampe - Real: Aus einem Sprung wird eine e-Funktion, genaugenommen die Lade-/Entladekurve eines Kondensators). Somit springt also ein Helligkeitspegel nicht mehr von 0 auf 100 sondern nähert sich in einer erst steilen, dann immer weniger steilen Kurve an die 100 an. Am Bild merkt man das daher, daß sich in den Schwarz-Weiß-Wechsel ein paar graue Pixel einschleichen, sprich der Wechsel wirkt unscharf.

Wie kann man

dem Schärfeverlust entgegenwirken? Ein Hochpass wirkt idealerweise wie

ein Differential. Heißt er gibt die Tangentensteigung an. Manch ein Mathematiker

wird mir an den Hals springen wenn ich jetzt einen Sprung differenziere, aber

ich sage einfach "Wir Elektrotechniker können das!": Aus einem

Sprung wird idealerweise ein sogenannter Dirac-Impuls. Das ist ein in der Natur

nicht vorkommendes Signal unendlichen hoher Amplitude und unendlich schmaler

Breite. Näherungsweise in der Natur zu beobachten z.B. bei Stroboskop-Scheinwerfern

(Optik), dem Stoß gegen eine Billard-Kugel (Mechanik), einem Pistolen-Knall

(Akustik) oder einem Blitzeinschlag (Elektrotechnik). Wichtig ist nur, sich

an den Mathematikunterricht und das Differential zurückzuerinnern: Es gibt

die momentane Tangentensteigung im Punkt X an. Der Hochpass ansich (mit ausreichend

hoher Grenzfrequenz) bewirkt also als Differential eine Kantenerkennung, man

sieht vom Urpsrungsbild nur noch scharfe Kanten. Also: Hochpass -> Differential

(Ideal: Gibt Tangentensteigung an - Real: Kanten werden steiler, Überschwingen,

Rechtecke bekommen eine "Dachschräge" und klingen somit nach

hinten hin ab). Wie man aus dem Mathematikunterricht weiß ist die Stammfunktion

die Umkehrung des Differentials und obendrein wichtiger Bestandteil des Integrals.

Das ist auch ungefähr das Verfahren mit dem die billig zu realisierenden

Eingangsstufen niederpreisiger TV-Karten arbeiten. Hochpass, Tiefpass und ein

Verstärker der Eingangspegel gleich Ausgangspegel hält. Leider neigt

das zum Überschwingen und daraus resultierenden Doppelkonturen.

Wie kann man

dem Schärfeverlust entgegenwirken? Ein Hochpass wirkt idealerweise wie

ein Differential. Heißt er gibt die Tangentensteigung an. Manch ein Mathematiker

wird mir an den Hals springen wenn ich jetzt einen Sprung differenziere, aber

ich sage einfach "Wir Elektrotechniker können das!": Aus einem

Sprung wird idealerweise ein sogenannter Dirac-Impuls. Das ist ein in der Natur

nicht vorkommendes Signal unendlichen hoher Amplitude und unendlich schmaler

Breite. Näherungsweise in der Natur zu beobachten z.B. bei Stroboskop-Scheinwerfern

(Optik), dem Stoß gegen eine Billard-Kugel (Mechanik), einem Pistolen-Knall

(Akustik) oder einem Blitzeinschlag (Elektrotechnik). Wichtig ist nur, sich

an den Mathematikunterricht und das Differential zurückzuerinnern: Es gibt

die momentane Tangentensteigung im Punkt X an. Der Hochpass ansich (mit ausreichend

hoher Grenzfrequenz) bewirkt also als Differential eine Kantenerkennung, man

sieht vom Urpsrungsbild nur noch scharfe Kanten. Also: Hochpass -> Differential

(Ideal: Gibt Tangentensteigung an - Real: Kanten werden steiler, Überschwingen,

Rechtecke bekommen eine "Dachschräge" und klingen somit nach

hinten hin ab). Wie man aus dem Mathematikunterricht weiß ist die Stammfunktion

die Umkehrung des Differentials und obendrein wichtiger Bestandteil des Integrals.

Das ist auch ungefähr das Verfahren mit dem die billig zu realisierenden

Eingangsstufen niederpreisiger TV-Karten arbeiten. Hochpass, Tiefpass und ein

Verstärker der Eingangspegel gleich Ausgangspegel hält. Leider neigt

das zum Überschwingen und daraus resultierenden Doppelkonturen.

Wie geht es also besser? Was macht man an der Hifi-Anlage wenn hohe Frequenzen z.B. durch mangelhafte Lautsprecher abgedämpft werden? Man betont sie mittels eines Graphic Equalizers. Dieser inverse Tiefpass (so der technisch korrekte Begriff) wird beim Profiko 2099 von Eicke&Bemmerer als Cosinus-Entzerrer beworben. Und genau das tun die hochwertigeren Eingangsschärferegler besserer Produkte. Das neigt nicht zum Überschwingen, hat aber einen anderen Nachteil: Zum einen ist auch Rauschen oft hochfrequent oder hat zumindest hochfrequente Anteile und wird somit stärker betont, zum anderen betont man die hohen Frequenzen zu stark bekommt man Oberschwingungen die sich über das normale Signal legen und somit ein statisches Rauschen.

Mit dem Klick auf das Bild könnt ihr die Erklärung der Hochpass, Tiefpass und "Equalizer"-Effekte noch mal in einem PDF in Bilder gefasst sehen

Schritt 2: Auswahl der Hardware

Theoretisch ist digital die schlechteste Form ein Video zu speichern. In der Theorie ist die beste Form immer noch die gute alte chemisch entwickelte Filmrolle wie sie Nostalgie-Hobbyfilmer noch von der alten Super8 kennen. Als Beispiel eine Parallele aus der Fotografie: Mir liegen (leider nicht bestätigte) Zahlen vor nach denen schon ein preisgünstiger Kleinbild-Fotofilm von der Körnung her eine Auflösung einer Digitalkamera mit ganzen 18 Megapixeln erreicht. Angesichts der Tatsache, daß die höchstauflösende Digitalspiegelreflexkamera der Welt gerade mal 16 Megapixel erreicht und nackt und ohne Objektiv schon so viel kostet wie eine komplette professionelle analoge Fotoausrüstung mit Objektiven, Filtern und Stativ, und die Auflösung auch mit der Kompaktknipse für 30 Euro nicht schlechter wird sind das schon beeindruckende Zahlen. Auch wenn die Qualitäten bei Analog sicherlich andere sind da sie auch von Faktoren wie Objektiv und Einstellmöglichkeiten abhängen, die Digitalfotografie ist von gleicher hoher Auflösung für 30 Euro Kompaktknipsen und mehrere 1000 Euro teurer Spiegelreflex noch weit entfernt. Ähnlich verhält es sich bei der Filmrolle. Immer wenn eine neue, noch höher auflösende Fernsehgeneration kommt, wie zur Zeit die Umstellung von PAL auf HDTV, tastet man den Film einfach wieder neu ab und erhält noch viel bessere Qualität und bislang ungesehene Details. Und bis man eine digitale Auflösung gleich der Filmrollenauflösung oder eine Leinwandgröße bei dem man einzelne Pixel sieht erreicht hat dürfte es auch noch ein wenig dauern. Die Nachteile der Filmrolle liegen natürlich auch auf der Hand: Kratzer und Staub können den Film verunstalten, die Handhabung ist kompliziert, das Material anfällig, und Videoschnitt mit seinen begrenzen Mitteln wird noch wörtlich mit Schere und Kleber ausgeführt.

Etwas schlechter ist die analoge Speicherung von Videodaten die mittels eines Bildsensors (feste Auflösung, keine Möglichkeit der Neuabtastung in höherer Auflösung) abgetastet wurden. Ja, in der Tat sind professionelle analoge Videokameras theoretisch besser als professionelle digitale Kameras. Im Analog-Bereich hat man keine Wertquantisierung und keine verlustbehafteten Spartricks (Weglassen von Farbinfos in YUV 4:2:2, 4:1:1 oder 4:2:0, verlustbehaftete JPEG (MJPEG, DV) oder MPEG-Kompression, ...). In einer Consumer-Umgebung kann man diesen Effekt ebenfalls bei Sat-Empfang beobachten: Bei einem wirklich hochwertigen Sat-Receiver und absolut ungestörtem Empfang ist der analoge Empfang besser als der digitale. Der Nachteil bei analoger Speicherung ist weiterhin die hohe Stör- und Fehleranfälligkeit (Rauschen, Banddefekte mit entsprechenden Folgen für das Material, Kopierverluste). Analoger Videoschnitt ist möglich und steht in den Möglichkeiten dem Digitalen in kaum etwas nach. Allerdings müssen sämtliche Quellen synchron anlaufen und die Bilder müssen mittels per Blackburst oder Wordclock getakteten Timebase-Correctors alle auf den gleichen Takt gebracht werden.

Digital stellt mit Zeit- und Wertquantisierung sowie verlustbehafteten Datenreduktionsverfahren das untere Ende dar. Aber: Digital hält konstante Qualität, es sei denn das Medium oder das übertragene Signal wird derart beschädigt, daß keine Wiederherstellung mittels Fehlerkorrekturdaten mehr möglich ist. Und Videoschnitt war noch nie so einfach und vielfältig.

Soweit die Theorie. Die Praxis lautet eher "Geiz ist geil" und "Was nix kostet ist auch nix". Ein VHS-Gerät ist nun mal keine highendige Betacam-SP Maschine, VHS-Geräte rauschen extrem und haben keine sonderlich hohe Bandbreite. Billige Kabel verstärken Rauschen, Unschärfe und Doppelkonturen (z.B. durch Leitungsreflexionen da der Wellenwiderstand von 75 Ohm missachtet wurde). DV-Camcorder hingegen liefern ein klares Bild das volldigital ist und somit keinerlei Gefahr von Überspielverlusten birgt, einfach Camcorder in den PC einstecken und überspielen, kein Parametergewusel an den Analogeingängen, kein Einfädeln von Filmrollen in den Abtaster. Filmrollen werden sich Hobbyfilmer und auch die meisten Profis eh nicht mehr antun wollen, desweiteren dürften die meisten Aufnahmen ohne Erfahrung mit Ausleuchtung, Belichtungszeit und ähnlichem auf Filmrolle schlechter werden als mit einer Chip-Kamera mit Belichtungsautomatik und Weißabgleich. Bleibt nur noch die Frage ob Analog oder Digital. Solang man nicht gerade sowieso aus irgendwelchen Gründen mit Betacam SP liebäugelt dürfte die Antwort von Privatanwender wie Profi eindeutig digital heißen. DV ist zwar schlechter als optimales Analog, aber besser als Pfusch-Formate wie VHS allemale.

Soweit zum kleinen Schwenk in die Welt chemischer, analoger und digitaler Foto- und Videokameras, für alle die außerdem noch nach der optimalen Videokamera suchen. Der Haupt-Zweck des Guides: Videos die noch nicht digital sind in digitale Form überführen, und das möglichst optimal. Auf die guten alten Filmrollen will ich dabei weniger eingehen, da das Thema aufgrund der recht exotischen Bildwiederholfrequenz und des komplexen Aufbaus der Überspiel-Vorrichtung einen Guide für sich ausmachen würde, hier geht es mehr um die alten Schätzchen auf VHS.

Wer glaubt, zum überspielen analoger Videos auf den PC benötigt man nur einen Videospieler und eine Aufnahmekarte hat recht - oder auch nicht. Auf dem Weg zum optimalen Bild gibt es nämlich noch andere Geräte auf dem Signalweg zur Karte und somit will ich bei TBCs und Enhancern anfangen. TBC mag zwar wie eine Krankheit klingen, hierbei handelt es sich aber um einen sogenannten Timebase Corrector. Dieser ist beim überspielen analoger Quellen unbedingt empfehlenswert da es bei der analogen Übertragung zu Signalstörungen aller Art kommen kann die sich dann durch verzerrte Ränder, Farbfehler oder ein unsauberes Sync-Signal (das zu verlorenen Bildern ("dropped Frames" führt) äußern. So ziemlich allen Fehlern die bei der analogen Übertragung und Speicherung auftreten kann man, im gewissen Maße zumindest, mit einem TBC recht erfolgreich auf die Pelle rücken. Nun sind TBCs ziemlich teuer, wer glaubt er wäre nicht der Freak und bräuchte keinen kann es auch ohne probieren. In den meisten Fällen sind die Ergebnisse immer noch sehr brauchbar, jedoch gilt je älter die Aufzeichnung und je höher die Ansprüche umso empfehlenswerter ist ein TBC. Die S-VHS Top-Modelle von JVC und Panasonic haben digitale TBCs sowie eine digitale Rauschunterdrückung bereits eingebaut. Der zweite empfehlenswerte Schritt auf dem Weg zur Videokarte ist der Enhancer. Damit sind keine zweifelhaften Signalaufbesserer gemeint sondern Geräte mit denen man Parameter wie Farbe, Kontrast, Helligkeit, Sättigung und in manchen Fällen Schärfe und Rauschen einstellen und filtern kann. Solche Enhancer gibt es einzeln, manchmal sind sie in Kombination mit TBCs, und im Consumer-Bereich auch häufig in Kombination mit Mischpulten zu finden. Es ist auf jeden Fall empfehlenswert, das Signal vor der Aufnahme auf dem PC so weit wie möglich aufzuarbeiten. Zum einen spart es später Rechenzeit beim Filtern, zum anderen können durch bestimmte Arten von Bildstörungen (zu hell, zu dunkel, zu wenig Kontrast) auch Informationen unwiederbringlich verloren gehen. Wer glaubt auf einen TBC verzichten zu können und auch keinen Enhancer kaufen möchte hat die Möglichkeit, zumindest Informationsverlust durch falsch eingestellte Farben vorzubeugen durch Einstellung der Parameter für den Videoeingang der Videokarte. Unersetzlich für ambitionierte User und allgemein empfehlenswert sind TBC und Enhancer auf jeden Fall.

Beim Videorecorder reicht in der Regel der bereits vorhandene. Wer keinen hat, z.B. weil das alte Modell gerade das zeitliche gesegnet hat, oder wem das alte Gerät nicht mehr genügt, und Wert auf Qualität legt, sollte auf jeden Fall zu einem S-VHS Modell greifen die inzwischen durch die Bank zumindest rudimentäre Bildverbesserungen bieten. Ambitionierte User können gleich zu den Top-Modellen von Panasonic und JVC greifen die über eingebaute TBCs verfügen. Die Preise zwischen 350 und 450 Euro sind dabei noch vergleichsweise günstig, einen gebrauchten TBC bekommt man dafür in der Regel nicht. Die Laufwerke dieser Geräte sind ebenfalls für heutige Verhältnisse sehr robust gebaut. Aus meiner Erfahrung raus würde ich für sehr alte Videos eher zu einem JVC raten der deutlich besser mit widrigen Bedingungen wie starkem Rauschen oder exotischen Trackinglagen zurecht kommt, während für neuere Videos oder zum Aufzeichnen die Panasonic-Geräte ein besseres Bild liefern.

Bleibt nun noch das Herzstück der Aktion: Die Videokarte. Hier gibt es verschiedenste Modelle, von der Grafikkarte mit eingebautem Videoeingang über TV-Karten, PVRs, Capture Boards, DV-Bridges, DVB-Karten, bis hin zu Realtime-Schnittkarten.

Wo liegen nun die Vorteile und Nachteile der einzelnen Technologien?

- TV-Karte:

Die Lösung mit dem niedrigsten Preis. Diese Formulierung ist absichtlich gewählt da man über "billig" oder "preiswert" geteilter Meinung sein kann. Wohl auch weil es viele verschiedene TV-Karten gibt die unterschiedliche Qualitätsansprüche stellen. Da TV-Karten und der DivX Codec digitale Videokonservierung salonfähig machten hat sich ein großer Kult um diese Karten gebildet, jeder ist anderer Meinung. Die einen schwören auf Brooktree/Conexant (die legendären weil weit verbreiteten Bt848 und 878), die anderen auf Philips. Und auch über die Marken gibt es geteilte Meinungen wobei teuer nicht immer gleich gut bedeuten muß. Die Qualität der Wandler ist allerdings nicht die beste und man muß auf Softwarecodecs zurückgreifen da die Datenmengen mit über 30MB/s bei voller Auflösung sonst Überhand nehmen. Nutzern von TV-Karten mit Conexant Chipsatz empfiehlt sich der Einsatz der privat programmierten Open Source Treiber "Btwincap" die deutlich flexibler sind als die Originaltreiber die oft nur entweder CCIR601 (704x576) oder PC Square Pixel (768x576) und die Viertelauflösungen davon zulassen, jedoch nicht beides. Das größte Problem bei den meisten TV-Karten dürften die schlampig dimensionierten Kapazitäten und Induktivitäten am Eingang sein (klar, der Entwicklungsaufwand verhält sich proportional zum Preis, da wären sauber dimensionierte Filter am Eingang nur mit einem Glücksgriff zu erklären) die zu trägen Reaktionen und/oder überschwingen/einschwingen bei starken Farb- oder Helligkeitsänderungen führen können - oder um es mit den negativen Auswirkungen auf das entgültige Bild auszudrücken: zu helle oder zu dunkle "Schatten", Farbbluten und verfälschte Farben an harten Farbübergängen.

Der bekannteste TV-Karten Hersteller (der sich seinen Namen teuer bezahlen läßt) heißt Hauppauge. Bei "Geiz ist Blöd" spricht man beim Fragen den Namen lieber so wie man ihn schreibt (Haup-auge, Hau-pauge oder Haup-pauge) da der "geschulte" Berater sonst nicht weiß wovon man redet. Besagte deutsche Aussprachen sind jedoch genauso unsinnig wie die richtig niedlichen Versuche, den Namen französisch auszusprechen (was in "Ohpash" oder "Ohpahje" oder ähnlichem endet). Hauppauge ist indianisch und spricht sich, egal ob der Hersteller oder die amerikanische (Bundesstaat New York) Stadt, "Happack". Wenn ihr euch beim Kauf beim Profi also etwas weniger blamieren wollt fragt nicht nach "Haup-pauge" oder "Ohpahje" sondern nach "Happack" - wollt ihr euch garnicht blamieren fragt lieber garnicht danach.

Vorteile:

Verbreitet, geringe Kosten, einfache Bedienung und Einrichtung, zum Fernsehen voll geeignet (Vollbild, auf PC verzerrungsfrei)

Nachteile:

Versteckte Kosten durch Software-Codecs oder fehlende Schnittsoftware, Software-Codecs müssen bei Aufnahme zugeschaltet werden was die mitgelieferte Software manchmal nicht ermöglicht, Qualität Lotteriespiel (manchmal gut, oft aber nur minderwertige Wandler oder schlampig dimensionierte Filter am Eingang und wenige Einstellmöglichkeiten führen zu Farbproblemen (verstärktes Rauschen, falsche Farben, Farbflächen, Farbbluten))

Typische Karten:

Hauppauge WinTV, Pinnacle PC-TV

- Grafikkarte mit Video-In/Out, "All-in-Wonder"

Im Prinzip eine TV-Karte in eine Grafikkarte integriert. Die Lösung hat allerdings nur Nachteile: Möglicherweise muß wegen der Anbindung an den AGP-Bus statt der bewährten Chips ein anderer verwendet werden und das ganze funktioniert nur mit speziellen Treibern die möglicherweise nicht so ausgereift sind wie Treiber anderer Chips. Doch selbst wenn die gleichen Chips verwendet werden wie auf der TV-Karte hat das Design Nachteile: Die Hitze der GPU verstärkt das thermisches Rauschen - und somit das Grundrauschen des Videoeingangs. Auch die hochfrequenten Strahlungen des schnell getakteten Grafikchips und ein induktives und kapazitives Übersprechen aufgrund der dicht an dicht gequetschten Leiterbahnen ist möglich und gar wahrscheinlich. Auch nicht zu verachten sind die enormen Mehrpreise der ViVo (Video In, Video Out) oder z.B. von ATI "All in Wonder" getauften Gesamtlösungen die sogar noch einen TV-Tuner besitzen. Dafür bekommt man auch eine Grafikkarte und eine TV-Kate. Die TV-Karte ist eine mittel- bis langfristig einmalige Investition und muß erst wieder getauscht werden wenn sich das Bus-System auf Nimmer Wiedersehen verabschiedet (wie einst bei ISA und in einigen Jahren PCI). Eine All-in-One Grafikkarte muß bei jedem Tausch sofern man weiterhin Video-In/Out will oder braucht wieder gegen eine neue All-in-One Karte tauschen. Und wenn der Grafikchip einmal bei Gamern "out" ist weil nicht mehr leistungsfähig genug haben auch All-in-One Karten gegenüber ihrer Standardausführungen keinen höheren Wiederverkaufswert mehr.

Vorteile:

Spart Steckplätze, z.B. in Barebones, bietet die gleiche Funktionalität wie Grafikkarte und TV-Karte zusammen

Nachteile:

Schlechtes HF-Design und somit Übersprechen und hitzebedingtes thermisches Rauschen setzen der Bildqualität zu, Wie bei TV-Karten Software-Codecs nötig, oder es kommen minderwertige MPEG2 Echtzeit Codecs zum Einsatz, Video-In keine einmalige Anschaffung sondern muß mit jeder neuen Grafikkarte neu mit bezahlt werden, hat am Ende der "Leistungs-Lebensdauer" der GPU-Leistung genauso Schrottwert wie eine billigere Karte ohne Video-In, schwerer zu bekommen und dennoch genauso teuer wie eine Grafikkarte und eine (nur einmalig zu kaufende) TV-Karte

- PVR (Personal Video Recorder)

PVRs sind "TV-Karte Deluxe". Im Prinzip gilt das gleiche wie bei TV-Karten allerdings ist Full-D1 in DVD-tauglicher Rechteck-Pixel Auflösung kein Problem und auch für einen Hardware-Codec ist gesorgt: MPEG2. Das Material ist ohne jeden Aufwand DVD-Tauglich, allerdings nicht schnittfähig (verlustbehaftete Komprimierung, nicht jeder Frame ein Keyframe) und MPEG2 von VHS ohne jede Aufarbeitung führt durch zu starke Bewegungen (auch Rauschen ist Bewegung) zu starken Komprimierungsartefakten. Schneiden sollte man es aufgrund der starken Komprimierungsverluste nur mit spezieller Software die nur an Keyframes (I-Frames) schneidet ohne neu zu komprimieren um Vorlauf, Nachlauf und Werbung zu entfernen - oder mit allerdings etwas teurerer Software die an jedem Frame schneiden kann ohne neu zu komprimieren (Smart Video Rendering Technology, z.B. in Cyberlink PowerDirector, Ulead Video Studio ab Version 7 und Canopus MPEGcraft DVD integriert).

Bei gutem Quellmaterial (direkt vom Fernsehen, gute S-VHS Aufnahmen) liefern PVR-Karten jedoch ein gutes schnell weiterverarbeitbares Video für DVD erstellen. Angenehm bei Fernsehaufnahmen ist außerdem der Timer mit integriertem EPG (Electronic Program Guide).

Vorteile:

Geringe Kosten, einfache Handhabung, sofort DVD-taugliches Material, zum Fernsehen geeignet, EPG-geführte Timer-Aufnahme

Nachteile:

Evtl. schlechte Bildwandler führen zu schlechter Qualität, MPEG2 nicht für Schnitt, Filterung oder sonstige Weiterverarbeitung geeignet, starke Artefaktbildung bei schlechtem Bildmaterial

Typische Karten: Hauppauge WinTV PVR

- MPEG2-Capturekarte

Der Übergang zwischen PVR und MPEG2-Karte ist fließend. Eine MPEG2-Karte kann alles was eine PVR auch kann, hat jedoch womöglich höherwertigere Wandler und ist anders ausgerichtet (Aufnehmen ist komfortabler als Fernsehen während es bei der PVR umgekehrt ist) oder bringt Zusatzfunktionen wie einen hardwareseitigen Transcoder der jedes beliebige Material in MPEG1 oder MPEG2 wandelt. Ansonsten gilt das was auch bei PVR-Karten gilt.

Nicht nur die Wandler, auch die Encoder sind oft hochwertiger als bei den PVR-Karten, hochpreisige Produkte wie die Canopus MPEGpro verfügen zusätzlich noch über einen Timebase Corrector und/oder einen Videofilter und erreichen so die Qualität die man auch durch softwareseitiges Filtern und Encoding von unkomprimiertem Material erreichen würde.

Vorteile:

Wie PVR, evtl. hardwareseitige Video-Transcoder die Videos schnell oder bei geringer Prozessorauslastung umrechnen sodaß man nebenher bequem ohne Beeinträchtigung arbeiten kann (Vidac Vmagic Serie)

Nachteile:

Wie PVR, evtl. jedoch bessere Wandler

Typische Karten:

Vidac Vmagic, Dazzle/Fast DVD Master, Canopus MPEGpro

- DVB-Karte (Digital Video Broadcasting)

Ist eine interessante Lösung für Besitzer von Digital-Sat (DVB-S), Digital-Kabel (DVB-C) oder digitalem terrestrischem Empfang (DVB-T). Alles was im Fernsehen läuft kann so ohne Qualitätsverlust digital aufgezeichnet und in den meisten Fällen ohne Umwandlung auf DVD gebrannt werden. Für das Thema hier, Restaurierung und Konservierung, sind die Karten jedoch uninteressant, außer evtl. die Vidac Vmagic DVB-S die DVB-Karte und MPEG2-Karte mit allen analogen Eingängen inklusive Hardware-Transcoder beinhaltet.

Vor- und Nachteile nicht behandelt da nicht analogaufnahmetauglich, bei Vidac Vmagic DVB siehe MPEG2-Karten

Typische Karten:

Technotrend Premium (inkl. baugleicher Nachbauten wie Hauppauge WinTV Nexus, Technisat Skystar 1 oder Siemens DVB-Baugruppe), Technotrend Budget (und baugleiche wie Hauppauge WinTV Nova), Technisat Skystar 2, Vidac Vmagic DVB

- MJPEG-Karte Einstiegsmodell

Eigentlich kann man MJPEG-Karten nicht in "Einstieg", "Midrange" und "High-End" unterscheiden. Zumindest nicht nach Preis oder Ausstattung. Ich habe es mich dennoch anhand bestimmter Merkmale getraut.

Als Einstieg definiere ich Karten die "preiswerten Lösungen" genüge tun. Betrachtet man DivX als preiswerte Lösung und setzt dafür quadratische Pixel voraus betrifft diese Gruppe also alle Karten die mit 768x576 Auflösung arbeiten.

Hochwertige Wandler, eine Hardwarekomprimierung im M-JPEG Verfahren mit je nach Karte zwischen 3.3 bis hin zu 10MB/s und ein Echtzeit-Timeline-Playback aus der unterstützten und mitgelieferten Videoschnittsoftware (meist Ulead Media Studio Pro, Adobe Premiere oder neuerdings auch Pinnacle Studio) selbstverständlich.

Im Lowend-Bereich finden sich die Anschlüsse für je nach Karte nur Video In/Out oder Audio/Video In/Out am Slotblech der Karte. Durch die M-JPEG Komprimierung halten sich Qualitätsverlust und Datenmenge in überschaubarem Rahmen und da jeder Frame ein Keyframe ist bleibt das Material auch schnittfähig. Vielfältige Einstellungsmöglichkeiten ermöglichen einen optimalen Farbabgleich des Eingangssignals, sodaß keine Farb- oder Helligkeitsinformationen durch zu geringe oder zu hohe Kontrast- und Helligkeitswerte verlorengehen.

Da die Karten allerdings aus vielen, teils exotischen und eigenwilligen Chips zusammengeschustert sind haben sich die MJPEG-Karten aller Art einen Ruf als "zickige Diva" erarbeitet - bislang ließ sich jedoch noch jeder Karte in jedem Computer das divenhafte Verhalten austreiben.

Vorteile:

Überschaubare Datenmengen, gute Qualität, verlustarmer Hardwarecodec, gute Schnittfähigkeit (mitgelieferte Software, gute Integration in diese, schnittfähiges Videomaterial)

Nachteile:

Oft zickige Treiber, Entry-Level-Karten mit 768x576 Auflösung erzeugen keine DVD-fähige Auflösung

Typische Karten:

Pinnacle miroVideo DC10 / Studio DC10, Pinnacle miroVideo DC20, Fast AV-Master

- MJPEG-Karte Midrange

Als Midrange-Karten stufe ich die Karten ein, die bereits die im Fernsehbereich übliche Rechteck-Pixel Auflösung mit Nutzdatenbereich (704x576) oder Full-D1 (720x576) beherrschen oder sich zwischen dieser und den PC-üblichen Quadratpixeln umschalten lassen.

Auch im Midrange-Bereich befinden sich die Anschlüsse noch am Slotblech oder an Kabelpeitschen, in einigen Fällen bekommt man einen "verlängerten Arm" in Form von zig zusammengefaßten Verlängerungskabeln die in einer Breakout-Box enden (im Beispiel der Pinnacle DC30 nennt sich besagte Konstruktion aufgrund ihrer blauen Farbe "Bluebox" was nichts mit der Effekt-Bluebox zu tun hat). Vereinzelt fehlt auch im Midrange-Bereich noch der Soundteil der anderen sinnvollen Features wie einem Firewire-Anschluß (Electronic Design AnDi) weichen mußte. Zwar ist hier kein Locked Audio möglich, mit einer vernünftigen Kombination aus Videokarte, guter Soundkarte und guter Capturesoftware kommt auch hier der Ton nicht aus dem Tritt. Ansonsten gilt gleiches wie auch schon im Low-Cost Einsteigersegment.

Vorteile:

Siehe Einsteiger-MJPEG

Nachteile:

Oft zickige Treiber

Typische Karten: Electronic Design AnDi, Pinnacle miroVideo DC30 Serie

- MJPEG-Karte High-End

Im Highend-Bereich findet man keine Quadratpixel-Auflösung mehr da das Material in der Regel für Ziel Broadcast oder DVD verwendet wird. Außerdem bieten Karten im Highend-Segment derart viele Anschlüsse, daß an einen Anschluß an Slotblech oder Kabelpeitsche nicht mehr zu denken ist. Man greift gleich zu externen Breakout-Boxen oder Connection-Bays für den 5.25" Laufwerkseinschub. Desweiteren finden sich auf den professionellen Karten auch z.B. zusätzliche Features wie DV-Eingänge (i-Link Firewire), SCSI-Controller, Videorecorder-Steuerung über Lanc oder Panasonic 5-Pin oder oder einen Testbildgenerator Komponenteneingänge wie sie im Studio bei Betacam-SP Maschinen genutzt werden. Der Onboard Audio-Teil ist eine Selbstverständlichkeit, natürlich hochwertig und mit Locked-Audio (Video- und Audiostrom fest verbunden sodaß Bild und Ton bei Bildverlusten nicht asynchron werden).

Vorteile:

Siehe Einsteiger-MJPEG, außerdem hochwertige, vielseitige Anschlüsse, Profi-Features, Mehrwert durch Zusatzmodule auf der Karte, optimale Handhabe von schlechten Signalen

Nachteile:

Oft zickige Treiber, Neupreise im 4-stelligen Euro-Bereich

Typische Karten (ausführlicher weil die Karten sich stark unterscheiden):

Pinnacle miroVideo DC50 (externe Anschlußbox mit Ein/Ausgängen für XLR-Audio, Cinch-Audio, S-Video, Composite, Component und Blackburst)

Electronic Design DV-Card/AV-Card (Frontpanel mit Ein/Ausgängen für Audio, Composite Video, S-Video, i-Link DV, Lanc/Panasonic 5-Pin, IR-Geber/Nehmer, Headphone/Micro, zusätzlich bei AV-Card Adapec Ultra-Wide SCSI-Controller, i-Link bei der AV-Card nur nutzbar mit Zusatzmodul, bei der DV-Card bereits freigeschaltet)

- AV-DV Bridge und Firewire/DV Kombikarten, DV/D8-Videokamers

Auf den ersten Blick wirkt DV attraktiv: Nur 3.6MB/s und auf NTFS keine Größenbegrenzung der AVI-Dateien. Alt-eingesessene Profis werden jedoch erst mal skeptisch dreinblicken: Die JPEG-Artefakte in 3.6MB/s Motion-JPEG sind nämlich deutlich sichtbar. Doch arbeitet DV mit einigen wirklich cleveren Tricks und neuesten Kompressionsalgorithmen und erreicht so eine Kompressions-Qualität, für die man mit MJPEG mehr als die doppelte Datenrate benötigt. DV hat auch einen Nachteil, bei PAL wird mit einem Farb-Subsampling von 4:2:0 gearbeitet, heißt insgesamt teilen sich 4 Pixel (in einem 2x2 Block) die je einen eigenen Helligkeitswert haben einen gemeinsamen zweikomponentigen Farbwert mit 8 Bit pro Komponente. Das kann an bestimmten Stellen zu leichten Farbartefakten führen.

Bei stark verrauschtem Material kann es sinnvoll sein, möglichst hohe Datenraten zu nutzen, bei MJPEG sind je nach Karte und Codec ja immerhin bis zu 10MB/s mögliuch, bei DV ist man auf die 3.6MB/s festgenagelt. Jedoch gibt es brauchbare externe (z.B. in TBC-Filtern wie den Darim M-Filter Karten) und auch interne (wie beim Canopus ADVC-300) Rauschfilter. Bei gutem bis mittelmäßigem Material und/oder dem Einsatz von Filtern ist DV brauchbar, schlechtes Material sollte man lieber unkomprimiert oder mit noch weniger stark komprimierten Codecs aufnehmen.

Die Einstellung einstellbarer AV-DV-Converter erfolgt über Software und/oder Regler am Gerät. Die meisten Geräte verfügen jedoch in Sachen Helligkeit, Farbe, ... über keine einzige Einstellmöglichkeit.

Einige hochwertigere DV-Kameras verfügen über einen Analog-Eingang und können je nach Ausführung und Freischaltung analoge Quellen auf DV-Band überspielen und dann über Firewire wieder rausspielen oder gar direkt von analog auf DV über Firewire wandeln. Noch besser sind einige Digital8 Geräte, vor allem wenn man vorher schon mit Video8 und Hi8 gearbeitet hat: Denn die alten analogen 8mm-Bänder werden von einigen Digital8 Kameras direkt digital per Firewire ausgespielt, richtig edle Modelle verfügen hierfür sogar über einen Timebase Corrector.

Für die Karten gilt weitgehend das selbe, allerdings sind Lowcost-Modelle oft nur dumme Capture-Karten die das Material unkomprimiert an Software-Codecs weiterleiten (Pinnacle Studio AV/DV) oder gleich hochleistungsfähige Realtime-Editing-Karten (Canopus Storm, Matrox RT10)

Typische Konverter: Dazzle Hollywood DV Bridge, Canopus ADVC-50/55/100/300/500, ADS Tech Pyro AV

Typische DV-Karten ohne Beschleuniger-Funktion: Canopus AceDVIO

Typische DV-Karten mit Realtime-Edit-Funktionen: Pinnacle DV500, Canopus Raptor RT, Canopus Storm, Canopus Rex-RT, Matrox RT10

"Untypische" DV-Schnittkarten: Pinnacle Studio AV/DV und AV/DV-Deluxe: Diese Karten haben keinen eigenen Audio-In (nur Video In und Audio/Video Out), haben keinen Hardware-Codec und laufen mit proprietären Treibern.

- SDI

SDI, Serial Digital Interface, wird im Profibereich eingesetzt und ist z.B. an Digital-Betacam Geräten zu finden. Bei SDI werden die Daten digital übermittelt, in der Regel mit einem Farbsampling von 4:2:2 (zwei benachbarte Pixel mit jeweils eigener Helligkeitsinformation teilen sich einen gemeinsamen zwei-komponentigen Farbwert), übertragen wird allerdings nicht mit 8 Bit pro Datenwort sondern mit 10 Bit. Das ganze obendrein noch unkomprimiert, also eine recht hohe Datenmenge. Dafür wird hier auch garantiert nichts mehr verfälscht, da es auch keinen Analogzuspieler gibt der feiner auflöst als die digitale SDI-Übertragung. Auch Betacam SP Geräte aus dem Profibereich haben nur halb so viel Farbbandbreite wie Helligkeitsbandbreite (also 4:2:2).

Typische Analog<->SDI-Wandler: Blackmagic Decklink Multibridge, Vortex Digibox A2D/D2A

Typische SDI-Karten: Blackmagic Decklink

Typische SDI-DV-Wandler: Canopus ADVC-1000, Datavideo DAC-5

Sonstige Hardware

Und auch ein kleines Wort zum Thema Festplatte möchte ich noch verlieren. Videos erzeugen riesige Datenmengen. Für ein unkomprimiertes Full-D1 Video fallen 720x576 Pixel mit je 3 Byte (YUV 4:4:4 oder RGB24) an und das ganze 25 mal pro Sekunde. Eine Sekunde hat somit 720*576*3*25 Bytes. 31104000 Bytes pro Sekunde - da sind die für den Ton bei 48KHz 16 Bit Stereo anfallenden 192000 Bytes pro Sekunde ja Peanuts. Man schlägt sich also im Extremfall mit über 31MB pro Sekunde herum. Okay, niemand wird Videos unkomprimiert aufzeichnen aber ein broadcast-taugliches Full-D1 Auflösung Video mit M-JPEG Komprimierung hat immer noch satte bis zu 10MB/s. Die Geschwindigkeit der Festplatten ist zumindest beim Einsatz eines Codecs zur Komprimierung nicht mehr das Problem, auch die unkomprimierten 31MB/s stecken moderne Festplatten locker weg, wenn auch nur im absolut störungsfreien Betrieb. Aber nebenher surfen und chatten sollte man beim Aufnehmen sowieso unterlassen. Wichtig ist es nur, genug Platz zu haben für das was man aufnehmen möchte. Der Freak ansich kann natürlich gerne zu einem RAID0-Stripe aus 4 WD-Raptor Festplatten mit 10.000rpm und 72GB pro Festplatte greifen. Nötig ist das jedoch nicht, in Größe und Geschwindigkeit ausreichend sind ebenfalls 120-160GB Festplatten mit 7200rpm wie die Seagate Barracuda 7200.7, um nur zwei Beispiele zu nennen die zum Zeitpunkt als dieser Guide geschrieben wurde aktuell waren.

Die Auswahl der CPU ist Geschmackssache. Fakt ist: Jede moderne CPU ist schnell genug für Videobearbeitung auf semiprofessionellem Niveau. Denn die Karten komprimieren entweder in Hardware oder man setzt für die Aufnahme auf "schnittfähige" Codecs wie MJPEG, DV oder HuffYUV, die äußerst CPU-schonend sind. Es gibt zwar Freaks, die DivX in Echtzeit aufnehmen wollen (Nachteile bei der Bildqualität siehe MPEG-Echtzeitaufzeichnung bei der Abhandlung über die MPEG-Karten), worfür man sicher immer noch eine extrem starke CPU (für hohe Auflösungen) braucht. Aber da Echtzeit-DivX über alle Maßen unsinnig ist kann man sich die CPU-Power auch sparen. Die Leistung brauchen Restaurations- oder Effektfilter und auch manche Übergänge beim Schneiden. Mit einer ausgeklügelten Filterkette kann man schon mal eine Render-Geschwindigkeit von unter 5fps erreichen (also mehr 5 mal so lang wie das 25fps Originalmaterial). Welche CPU man sich kauft sollte man jedoch vom Geldbeutel abhängig machen. Intel und AMD geben sich derzeit in Preis und Leistung fast nichts, selbst auf den aktuell schnellsten CPUs können hochwertige Filterketten noch extrem langsam laufen, also geduldig muß man immer sein. Wer die Filterung und Speicherung über Nacht (oder tagsüber während man arbeiten ist) oder im Hintergrund mit niedriger Priorität laufen lassen kann, braucht keine Extrem-CPU sondern nur geringfügig mehr Geduld als mit Extrem-CPU.

Wer mit professionellen hochmodernen Schnittsystemen wie Adobe Premiere Pro oder Canopus Edius 2 arbeiten möchte kann unter normalen Umständen auch schon mit einer 2GHz-Klasse CPU ordentlich arbeiten. Hier sollte man allerdings auf Intel setzen, da die derzeit aktuellen Schnittsysteme allesamt noch nicht auf 64 Bit compiliert sind (ein Athlon 64 nützt also nichts), jedoch auf das Intel Hyperthreading und SSE2 von Intel optimiert sind. Sobald man die Echtzeit-Features und viele Videospuren nutzen möchte, beginnt es erst mit einem hochleistungsfähigen 1-CPU P4-Extreme oder Mehr-CPU Xeon und/oder einer Realtime-Schnittkarte von Matrox oder Canopus, richtig Spaß zu machen. Wer eine Canopus Storm oder Matrox RT10 sein Eigen nennt braucht wieder keine so große CPUs da die Karten der CPU mit ihren hochleistungsfähigen Hardware-Codecs unter die Arme greifen (nur bei DV-Material, keine anderen Codecs), allerdings dürfte der Hobby-Cutter wohl die bezahlbare Leistung mehr aus einer Top-CPU als aus einer RT-Karte holen können die sich in Preis und Ausstattung wohl mehr an den Profi wendet.. Je nach Ansprüchen und Schnittsoftware sind eine Intel-CPU in der 2-3GHz Klasse und ggf. eine Realtime-Schnittkarte sinnvoll, für Consumer-Schnittsoftware weniger, für richtig extreme Software eher mehr.

Schritt 3: Anschließen und Aufnahme

Anschließen klingt für viele nach "Kabel rein". Dennoch gibt es einige Tricks. Ich will schon vor allem deshalb detailliert auf das Thema eingehen, da ich letztens in der Computer Bild lesen mußte, daß man einen Videorekorder am besten mit einem Scart-Adapter auf Cinch-Audio, Cinch-Composite-Video und S-Video-Ausgang an den S-Video-Eingang der TV-Karte anschließt. Den ganzen Text über fixierte man sich auf den S-Video Ausgang des Adapters und den S-Video Eingang der TV-Karte, ohne dabei zu erwähnen, daß bei den weit verbreiteten VHS-Rekordern nur ein Composite-Signal rauskommt, das Bild am Eingang also schwarz-weiß wäre, und man diesen Anschluß nur am S-VHS Rekorder nutzen kann, am VHS-Rekorder den Composite-Ausgang nutzen müßte. Ich hoffe hier, das Thema Verkabelung möglichst komplett besprechen zu können.

Zum ersten die Auswahl der Kabel. Hiermit meine ich nicht sauerstofffreie Goldkabel die von einem Voodoo-Priester mit lustigem Hut bei Mondfinsternis gesegnet wurden. Viel mehr meine ich kleine Tricks beim Kabel-Einkauf und beim Anschließen. Kabel können sehr wohl die Qualität beeinflussen. Teuer bedeutet hierbei nicht gleich gut. Denn sonst müßten die Kabel von der Hama Kabelwand bei den großen Elektromärkten ja absolute Top-Produkte sein. Der kleine Fachhändler um die Ecke hat in der Regel deutlich bessere Kabel zu einem Bruchteil des Preises der überteuerten Taiwan-Billigkabel aus den Elektromärkten. Zwar sind auch vergleichsweise dicke Kabel mit dicken Gummimänteln kein zwingendes Qualitätsmerkmal, wird einem jedoch zugesichert, daß jede einzelne Ader einzeln geschirmt ist und weist das Kabel eine gewisse Dicke auf und der Stecker wirkt robust kann man schon relativ sicher sein, ein gutes Kabel zu erwischen. Der nächste Schritt ist es dann, die Kabel in der richtigen Reihenfolge in die richtigen Anschlußbuchsen zu stecken.

Wer nur einen Videorecorder und eine Aufnahmekarte/DV-Box hat kann in der Reihenfolge nicht viel verkehrt machen. Höchstens noch die Auswahl der Buchsen ist etwas tricky. Denn viele Billig-Produkte aus dem Bereich der TV-Karten neigen dazu, bei Composite Video blassere Farben darzustellen als bei S-Video mit getrenntem Y/C-Signal. Bei guten Produkten sollte das jedoch nicht vorkommen. Daß S-Video immer besser sein soll als Composite ist ein Irrglaube. Denn Geräte, die eine 3D Y/C Separation durchführen (z.B. Canopus ADVC-300, nur bei NTSC) haben bei VHS-Videos bei Zuspielung über Composite ein geringfügig stabileres Bild als bei S-Video. Selbst bei PAL, obwohl dort keine 3D Y/C Trennung durchgeführt wird (technisch nicht möglich aber auch nicht nötig), vermutlich wird durch die geringere Bandbreite und der dadurch entstehenden leichten Unschärfe das leicht ausgefranste Bild noch etwas stabilisiert. Je nach Quelle ist Composite also tatsächlich besser als Y/C. Man muß halt einfach ausprobieren. Bei S-VHS Bändern ist das Bild natürlich bei S-Video besser. Wer der besseren Farben wegen seinen VHS-Recorder an die S-Video Buchse der TV-Karte anschließen will sei jedoch gewarnt: Oft hat man dann garkeine Farben mehr. VHS-Recorder übertragen ihr Signal Composite, heißt die Helligkeits- und Farbinformationen werden auf einer Leitung übertragen, das Farbsignal überlagert als Sinus das Helligkeitssignal das ein reines Amplitudensignal ist. Bei S-Video werden Farbe und Helligkeit über zwei Leitungen übertragen. Das Composite-Signal landet bei der Scart->S-Video Verkabelung auf der Y (Helligkeits) Leitung. Jedoch wird nur die Helligkeitsinformation ausgewertet. Die C (Farb) Information überlagert wie schon gesagt als Sinus die Y-Information, womit am S-Video Eingang nicht gerechnet wird, die C-Leitung des S-Video Kabels ist tot. Somit kann nur hell-dunkel unterschieden werden, das Bild ist schwarz-weiß. In seltenen Fällen kann es auch vorkommen, daß der Farbträger auf dem Y-Signal erkannt, jedoch falsch ausgewertet wird, das Bild hat nur blasse Farben, ein Moire-Muster und sonstige seltsame Störungen. VHS- und Video8-Geräte dürfen also nie per S-Video angeschlossen werden, bei S-VHS und Hi8 ist S-Video oft besser, kann aber in seltenen Fällen durch seine Vorteile Nachteile bekommen (Kantenflimmern durch mehr Schärfe stärker sichtbar)

Wer auf dem Weg zwischen dem Videorecorder und dem Aufnahmegerät noch Bildverbesserungen einsetzt sollte diese in einer gewissen Reihenfolge anschließen. Am sinnvollsten ist es, den Timebase Corrector direkt nach dem Zuspieler einzuschliefen. Grund: Viele Enhancer (wie die Mischpulte mit Umschalter) könnten bei schwachen Syncs die Sync-Signale verfälschen. Wer Jitter (wabernde Ränder) oder sonstige Störungen im Video hat fixiert diese möglicherweise so fest im Video da der TBC anständige Syncs bekommt und so den Jitter nicht mehr erkennt. Der TBC gehört also nach vorne, am einfachsten ist das mit einem Videorekorder mit eingebautem TBC den man einfach nur noch anschalten braucht. An dem sauberen Signal kann der Enhancer oder Umschalter oder was auch immer noch kommt eigentlich nicht mehr viel kaputt machen. Die Reihenfolge Zuspieler->TBC->Enhancer->Videokarte ist also sinnvoller als Zuspieler->Enhancer->TBC->Videokarte. Wer ganz auf Nummer Sicher gehen will und (finanziell - ist schließlich nicht billig) kann positioniert die TBCs im (oder direkt nach) dem Zuspieler und im (oder direkt vor) dem Aufnahmegerät (Videokarte/DV-Wandler) sofern noch Zwischenschritte erfolgen.

Das Aufnehmen ist bei vernünftigen Geräten nur noch ein Klick und Los. Die Software hängt in der Regel vom jeweiligen Gerät ab. Manche Karten erfordern abgestimmte Software, andere Karten arbeiten mit VfW oder WDM Treibern. Bei den einen liegt gute Software bei, bei anderen ist die Software derart schlecht, daß man besser auf gängige Software wie die Aufnahmemodule z.B. von Schnittsoftware oder auf Freeware wie Virtual Dub zurückgreift.

Zur Aufnahme empfiehlt sich ein schnittfähiger Codec. Das sind Codecs die die Daten zwar reduzieren, das jedoch mit nur minimalem oder ganz ohne Qualitätsverlust und jeden Frame als Keyframe (Vollbild) nutzen. Die gängigen sind DV, HuffYUV, MJPEG und Lossless MJPEG, wobei HuffYUV die mit Abstand größte Datenmenge produziert, die im schlechtesten Fall nahezu identisch mit der unkomprimierten Datenrate ist. Unkomprimiert aufnehmen empfiehlt sich deshalb nicht, da selbst moderne Festplatten, die in synthetischen Benchmarks über 70MB/s wegschreiben können, unter üblichen Betriebsbedingungen die Video-Datenmengen von 30MB/s wegzuschreiben, denn jede kleine Nebentätigkeit, und sei es nur der Zugriff auf den Swapfile oder eine Temporärdatei, bringt den Datenfluß aus dem Tritt und läßt den Aufnahmepuffer überlaufen. Das Ergebnis sind Dropped Frames.

Natürlich kann man auch mit MPEG-basierten Codecs (MPEG1, MPEG2 und MPEG4-Derivate wie DivX, Xvid oder Windows Media) aufnehmen, jedoch hat dies einige Nachteile: MPEG-Komprimierung ist deutlich aufwändiger als die der "Schnitt-Codecs", heißt für Echtzeit-Vollbildaufnahme ohne Hardware-Unterstützung benötigt man eine recht starke CPU, ob DivX in Full-D1 in Echtzeit mit heutigen Rechnern überhaupt möglich ist, ist immer noch strittig, die einen sagen, es geht, die anderen sagen, es geht nicht. Der gravierende Nachteil wurde bereits bei der Hardware-Auswahl bei den PVR-Karten erklärt: MPEG-Komprimierung ist stark verlustbehaftet und nicht schnittfähig. In schnell bewegten Szenen - und auch Rauschen ist Bewegung - kommt es zu starken Kompressionsartefakten (sichtbare Klötzchen). Die Schnittfähigkeit wird durch die Tatsache eingeschränkt, daß zwischen den Keyframes (Vollbildern) viele Teilbilder liegen. Im Extremfall muß man, um Bild 10 aufzubauen, aus Bild 1 (Vollbild) und Bild 2-10 (Teilbilder nur mit Änderungen) Bild 10 rekonstruieren. Das zieht die Leistung der Schnittprogramme stark herunter, das Aufbauen der Timeline dauert jedes Mal mehrere Sekunden (bis 10 Sekunden auf einem Pentium 4 2400 mit zwei MPEG2-Clips in einer Media Studio Pro Timeline bei Einstellung "alle Bilder anzeigen" und Timeline-Skalierung 1s) während mit schnittfähigen Codecs die Timeline quasi sofort (unter einer Sekunde) aufgebaut wird. Scrubbing in der Timeline macht ebenfalls nur bei schnittfähigen Codecs wirklich Spaß und wird von MPEG2 stark ausgebremst, genau wie Realtime oder zumindest In-Time (zäh und somit langsamer als Echtzeit, aber nicht vorgerendet) Effektvorschauen langsamer werden (Realtime unter Umständen dann nicht mehr möglich). Auch das Rendern dauert länger und kostet wieder Qualität. Der Qualitätsverlust pro MPEG-Neukomprimierung ist durchaus vergleichbar mit dem pro VHS-Kopiergeneration, also schon deutlich merkbar.

Schritt 4: Störungen und ihre Beseitigung

- Dropped Frames

Dropped Frames entstehen durch diverse Fehler während der Aufnahme. Die Gründe können Störungen im Bildsignal aber auch im Programmablauf des Aufnahmeprogrammes sein. Dropped Frames sind unschön, jedoch auf dem Level von 5 Drops pro 10 Minuten unbedenklich, solang das Aufnahmeprogramm sauber arbeitet (und/oder die Videokarte Locked Audio beherrscht) und durch die verlorenen Frames Bild und Ton nicht auseinanderlaufen (anfangs synchron, gegen Ende hinkt der Ton dem Bild immer mehr hinterher). Dieses Level ist auch durchaus normal bei handelsüblichen Originalvideos und TV-Aufnahmen. Denn durch die Gleichlaufschwankungen des Videorecorders kann das Sync-Signal aus dem Tritt geraten, nach Kopiergenerationen oder Jahren des Lagerns ist es womöglich auch etwas zu schwach. Da muß schon mal der ein oder andere Frame fallgengelassen werden um neu zu synchronisieren.

Ist die CPU-Auslastung im gesunden Bereich (also nicht 100%, optimalerweise unter 50%) und arbeitet die Festplatte nur leise vor sich hin ohne hörbar (rattern) oder sichtbar (LED auf Dauer-Hell) auf Engpässe aufmerksam zu machen sind die Drops in der Regel auf die üblichen Störungen des Sync-Signals zurückzuführen. Vorsicht, "Signal Enhancer", ursprünglich gebaut, um den analogen Videokopierschutz zu umgehen, die das Sync-Signal nur auffrischen oder anhand des alten Syncs z.B. mittels PLL neu aufbauen bringen garnichts. Die Drops bleiben, werden vielleicht was weniger - aber stimmt der neu aufgebaute Sync nicht mehr mit dem alten überein kann es im Extremfall sogar zu wabernden Bildrändern (Jitter) kommen, die dann aufgrund des neuen sauberen, jedoch unsinnigen Syncs, noch nicht mal mehr durch einen Timebase Corrector behoben werden können. Sync-Signale korregieren sollte man nur mit einem Timebase Corrector, und das ist unbedingt empfehlenswert.

Fazit: Der Amateur kann im Zweifelsfall geringfügige Mengen an Dropped Frames verschmerzen, besser ist es jedoch, einen TBC zu benutzen. Flicklösung für Bt8x8-Besitzer: Während der Aufnahme das Bild in der Höhe um 8 Pixel kleiner machen (somit werden die unteren 8 Zeilen abgeschnitten die die Bt8x8 schon mal verwirren können, vorsicht, wenn man den Wert der Bildhöhe zu klein wählt fängt der Chip an statt abzuschneiden zu skalieren) und anschließend beim Nachbearbeiten auch noch oben 8 Pixel wegschneiden und die fehlenden 16 Pixel wieder letterboxen (Grund für das Wegschneiden oben: Die meisten Letterbox-Filter ergänzen bei 8 Pixeln ergänzen 4 oben, 4 unten und das Bild würde somit etwas nach unten verrutschen, schneidet man oben auch noch mal 8 weg kann man 16 ergänzen und hätte somit oben und unten 8 Pixel letterboxed). Funktioniert halbwegs, reduziert die Anzahl Dropped Frames enorm (vermeiden lassen sie sich so nicht, man umgeht aber einen Bug im Chip der gerade bei VHS-Material zu unnötig vielen Drops führt) ist aber nur eine Notösung.

Ein Wort zu Dropped Frames bei DV-Aufzeichnung: Die gibt es nicht. Die DV-Wandler haben ein eigenes Management für Sync-Probleme. Dropped Frames werden im Normalfall beim Aufnehmen von DV-Wandlerboxen oder DV-Camcordern per Firewire immer Null gemeldet werden. Sollte dies nicht der Fall sein, sprich es werden Dropped Frames gemeldet, beziehen sich diese auf verlorende digitale Frames aufgrund von Übertragungsfehlern. Das Material ist nach Fehlersuche und Beseitigung unbedingt neu aufzunehmen, denn das aufgenommene dürfte diverse Störungen enthalten.

- Wabernde Bildränder (Jitter)

Die gerade stehende Säule sieht aus wie eine Schlange im Wüstensand? Knickt der obere Bildrand ab? Hier ist in der Regel das Sync-Signal fehlerhaft. Sofern das Problem nicht, wie in seltenen Fällen, schon bei der Live-Aufnahme aus dem Fernsehen auftritt (normal sollte es hier keine Probleme geben, ein solcher Fall ist mir jedoch bekannt, ohne, daß ich eine Lösung dafür hätte), hilft hier nur ein Timebase Corrector. Viele, insbesonders ältere, TV-Karten und Videokarten verfügen über einen Umschalter ob die Quelle TV oder VHS ist, im Zweifelsfall kann probieren, die Störungen über diesen Schalter einzudämmen (normalerweise ist es kein Problem, den Schalter bei Live und VHS Bildern auf VHS stehen zu lassen, in seltenen Fällen, wie z.B. bei bestimmten Video-Funkübertragungssystemen kann das jedoch Probleme geben weshalb man den Schalter dort für das Bild auf Livebild/TV setzen muß).

- Kammeffekt 1 (Kantenflimmern an scharfen Konturen)

Wenn Kanten in wenig bis nicht bewegten Szenen leicht ausfransen hilft es in der Regel, einfach den Eingangsregler für "Schärfe" etwas zurückzunehmen.

- Kammeffekt 2 (Interlace-Effekt)

In schnell bewegten Szenen kann es vorkommen, daß Halbbild 1 (Zeilen 1, 3, 5, ...) und Halbbild 2 (Zeilen 2, 4, 6, ...) sich unterscheiden. Das sieht dann ungefähr so aus als würde man zwei Kämme ineinander verzahnen, das Bild auf diese auftragen und die Kämme dann leicht auseinanderziehen. Dieser Effekt ist normal. Das Fernsehbild wird nicht in 25 Vollbildern mit 720x576 aufgenommen, sondern mit 50 ineinander verwobenen Halbbildern mit 720x288. Diese Maßnahme stammt noch aus den Ur-Zeiten des Fernsehens, der eben immer noch mit dem Interlace (Zeilensprung) Verfahren arbeitet. Am Fernseher sieht man das nicht, der wurde für Interlace-Signale optimiert. Ein PC-Monitor soll jedoch progressive Bilder darstellen, die ohne Zeilensprung von oben nach unten aufgebaut werden. Daher sieht man plötzlich die Interlace-Streifen. Das ist kein Fehler. Für Zielformat DVD ohne Nachbearbeitung kann und sollte man das so lassen, nur muß man darauf achten, im MPEG-Encoder auch Interlace und die korrekte Halbbildreihenfolge einzustellen. Fürs Ziel PC kann man den Interlace-Effekt durch einen Deinterlacer (es gibt verschiedene Verfahren) abstellen. Das empfiehlt sich auch unter bestimmten Umständen zum für Schnitt bestimmtes Material, zum einen um Interlace-Streifen in bestimmten Effekten (skalieren, rotieren) vorzubeugen, zum anderen wenn man mit Zeitlupeneffekten arbeitet (wobei es zu einem ähnlichen Flimmereffekt kommen kann wie bei vertauschter Halbbildreihenfolge - einige Schnittprogramme wie Canopus Edius deinterlacen Material das unter 100% abgespielt wird automatisch). Im Normalfall kann man jedoch auch beim normalen Videoschnitt das Material Interlaced belassen, und auch wenn man bestimmte Szenen z.B. zwecks Zeitlupe oder eines aufwändigeren Transition- oder PiP-Effekt deinterlaced, Interlaced-Progressiv-Mischmaterial stellt kein Problem dar, da man progressives Material problemlos interlaced encoden kann. Progressives Encoding von Interlaced-Material ist hingegen nicht empfehlenswert.

Für DVD-Player ist es egal, ob das Material interlaced oder progressiv ist. Es kommt nur drauf an, daß es korrekt encoded wird. Beim Interlaced-Material muß es Interlaced und mit korrekter Halbbild-Reihenfolge codiert werden, bei Progressiv-Material empfiehlt sich zwar Progressiv (interlaced wird es vom DVD-Player beim Abspielen, für Progressive Scan Fernseher muß es dann garnicht mehr vom Player oder Fernseher deinterlaced werden), jedoch ist es auch kein Problem, Interlaced zu encoden. In beiden Fällen hat man dann beim Abspielen "Progressive Interlaced", sprich nur noch 25 statt 50 Bewegungs-Halbbilder, dafür bilden Halbbild 1 und Halbbild 2 zusammen ein progressives Bild.

- Kammeffekt 3/Stufeneffekt (Vertauschte Halbbild-Reihenfolge)

Sieht das Bild eigenartig stufig aus? Dann ist vermutlich (bei progressiven Bildern) die Halbbildreihenfolge vertauscht. Die Lösung hierfür trägt in Virtual Dub den Namen "Swap Field Order". Alternativ, und richtiger, wäre es möglich, einfach im Videocodec (z.B. der MJPEG-Codec - die meisten MJPEG-Karten arbeiten nämlich mit Top Field First, die Pinnacle DC50 mit dem bei vielen älteren Profiprodukten und DV üblichen Bottom Field First) MPEG2-Encoder die korrekte Halbbild-Folge einzustellen. Wer jedoch das Bild noch weiter bearbeiten will und die Halbbildreihenfolge nicht einstellen kann muß jedoch zum Swap Field Order greifen.

Ich will es mir an dieser Stelle nicht nehmen lassen, über einen anderen Guide abzulästern, den ich aus Fairness-Gründen jetzt nicht nenne: Dort wurde Swap Field Order allen Ernstes als Gegenstück zum Deinterlace-Filter angepriesen. Das stimmt jedoch nicht. Wer progressives Material encoden will kann dies ruhig progressiv tun, oder wie eben schon angesprochen progressiv interlaced. Und wer es ganz genau nimmt: Mit Motion Perfect von 25 auf 50 Frames pro Sekunde hochrechnen und die neuen Bilder dazuinterpolieren, von 720x576 auf 720x288 runterrechnen und je zwei Frames ineinander verweben. Möglich, aber sinnlos.

Das hier erwähnte Störbild durch vertauschte Halbbilder gehört zu der harmloseren Variante und taucht bei "Progressiv Interlaced" auf, heißt wenn man ein Bild hat, bei dem die zwei Halbbilder zusammen ein progressives Vollbild ergeben. Da zwischen den beiden Halbbildern keine Bewegung liegt kommt es nur zu einem Stufeneffekt, als würde man jede zweite Zeile vertauschen

- Zuckende, flimmernde Bewegung (Vertauschte Halbbild-Reihenfolge)

Die unangenehmere Folge von vertauschten Halbbildern entsteht bei echtem Interlaced-Material. Heißt wo in 25 Frames 50 Bewegungen auftauchen. Im zweiten Halbbild ist also schon ein anderer Bewegungsfortschritt zu sehen als im ersten. Das ist bei den meisten Materialien so. Vertauscht man hier die Halbbilder kommt es zu einem recht erheiterndem aber unschönen Effekt, der allenfalls als Partygag taugt um den Gästen einen zu hohen Alkoholpegel vorzugaukeln. Da die Halbbilder unterschiedliche Bewegungsfortschritte enthalten führt ein Vertauschen der Halbbilder bei Interlaced-Darstellung wie sie am Fernseher erfolgt zu einem Effekt wie dem Vertauschen von Vollbildern. Die Animation läuft also nicht mehr Bild 1-2-3-4-5-6-... sondern Bild 2-1-4-3-6-5-.... Man kann sich also vorstellen, was dabei für ein zitterndes Geflirre herauskommt, besonders bei schnell bewegten Szenen und Abspannen bei denen der Text von oben nach unten oder umgekehrt durchläuft.

Die Halbbildreihenfolge ist Top Field First bei Consumerprodukten wie TV-Karten und den meisten (semi-)professionellen MJPEG-Karten. Bottom Field First findet häufig bei älteren professionellen Produkten (Pinnacle DC50, Truevision Targa) sowie DV Anwendung.

- Eierköpfe vs. Ballonköpfe

Im Einleitungs-Kapitel habe ich bereits angesprochen, daß ein PC quadratische, ein Fernseher jedoch breitgezogene rechteckige Pixel hat. Dadurch wirken Bilder in der korrekten Fernsehauflösung 720x576 oder 704x576 auf einem PC ansieht wird feststellen, daß das Bild in der Breite gestaucht ist. Wer jetzt mit einer veralteten (oder mit veralteten Treibern betriebenen) TV-Karte oder einer veralteten MJPEG-Schnittkarte arbeitet die nur PC-Auflösung beherrscht und diese falsch weiterverarbeitet (z.B. nicht von 768x576 runterrechnen auf 704x576 sondern z.B. von 768x576 so viel abschneiden, daß 720x576 übrig bleibt) hat am Ende am Fernseher breit gezogene "Ballonköpfe".

Lösung: Das Theoriekapitel noch einmal lesen und das Größenverhältnis korrekt umrechnen. Bzw. bei 704/720x576 Aufnahmen die eh für DVD bestimmt waren am PC die Eierköpfe akzeptieren und das so lassen, am Fernseher ist es nachher wieder richtig.

Noch ein Spezialfall ist 16:9 Anamorph. Das wurde erfunden, um in den festgelegten 720x576 eine höhere Zeilenauflösung zu erreichen. Ist bei 16:9 das Bildseitenverhältnis 4:3 mit 16:9-Balken im Bild die wertvolle Zeilen einnehmen ist beim Anamorph-Verfahren das Bild sehr stark gestaucht, dafür ohne schwarze Ränder (bis auf den freien Overscan von 704+16 den man auch bei 4:3 ITU-R601 hat), Eierköpfe extrem. Entzerrt wird das ganze durch den DVD-Player (stellt man ihn auf 4:3-Fernseher) oder vom Fernseher (der erkennt, daß ihm der DVD-Player ein 16:9-Bild liefert). Sowohl 16:9 Letterbox (mit schwarzen 16:9-Balken im Bild und 4:3-Verhältnis) alsauch 16:9 Anamorph müssen beim Encoding entsprechend gekennzeichnet werden damit der DVD-Player weiß, auf welches Seitenverhältnis er stellen soll und ob er dem Fernseher mitteilen soll ob und welches 16:9 Format geliefert wird.

- Rauschen und "Fische"

Rauschen tritt bei analogem Material immer auf. Abhilfe schaffen diverse Rauschfilter. Die einen arbeiten über 2 Dimensionen (X, Y) und fügen dem Bild somit leichte Unschärfe zu, andere über 3 Dimensionen (X, Y, Zeit) wobei das Bild nicht mehr unscharf wird, jedoch ggf. leichte Bewegungsschlieren entstehen können. Mit gut eingestellten Filtern kann man das Bild perfekt entrauschen ohne ihm Schaden durch Bewegungsschlieren oder Unschärfe zuzufügen.

Fische sind kurzzeitige schwarze und weiße Drop Outs die bei gestörtem analogen Satellitenempfang entstehen können. Sie lassen sich durch den geschickten Einsatz von Rauschfiltern, Weichzeichnern und Scharfzeichnern etwas verkleinern, jedoch nicht eliminieren. Sicher ist es auch möglich, Fische komplett zu eliminieren, z.B. durch Zwischenwerte (Interpolation) aus den intakten Pixeln rund um den Fisch, jedoch wären hierzu wirklich intelligente und rechenaufwändige Filter nötig, insbesondere um die Fische auch korrekt zu erkennen. Mir ist kein für Normalsterbliche verfügbarer Filter (z.B. für Virtualdub oder Avisynth) bekannt, der das kann.

- Seltsames Geflirre in den unteren Bildzeilen (Head Switch Noise)